deep neural network에서의 backpropagation

backpropagation

원래 backpropagation(역전파)는 학습 방식이 아니라 perceptron에서 loss function의 기울기를 계산하는 알고리즘을 뜻하지만, 넓은 의미에서는 기울기를 이용한 학습 방식으로 쓰인다.

delta rule

https://en.wikipedia.org/wiki/Delta_rule

delta rule의 정의와 증명

delta rule은 backpropagation 방법 중 하나이다.

delta rule은 왜 multi-layer에서 사용할 수 없는가...

본론5에서와 같이 처음에는 신경망학습에서 delta rule이라는 방식을 사용해서 학습을 했다. 이 방식은 error에 대한 w의 미분 값에 상수를 곱해서 w의 조정값을 구하는 방식이다. 하지만 delta rule 방식은 싱글 레이어, 즉 단층 perceptron에서만 사용된다.

delta rule은 Mean Square Error를 이용하므로 Mean Square Learning Rule이라고도 불린다. 이 규칙은 한 번에 한 계층씩 이전 계층으로 back propagation 되므로 전체적인 조정을 이루지 못하고 생기는 오류가 input 레이어에 도달할 때까지 누적된다. (https://www.researchgate.net/publication/224398598_Performance_Comparison_of_Multi-layer_Perceptron_Back_Propagation_Delta_Rule_and_Perceptron_algorithms_in_Neural_Networks 논문 참고)

쉽게 말해서 hidden layer의 target을 알 수 없으므로 한 단계씩 back propagation하는 delta rule을 사용하는 것은 무리가 있다.

존재하는 weight 값을 동시에 학습할 수 없기 때문에

파란색 테두리처럼 끝에서부터 조정하고 싶은 w까지 거슬러오는 방식으로 backpropagation을 하는 것이 아니라 주황색처럼 한 단계씩 backpropagation을 하므로 중간 단계의 target 값을 알아야한다는 얘기 같다. (정확히 아직 이해하지 못했음)

multi-layer에서의 backpropagation

multi-layer에서는 편미분의 계산이 겹치는 경우가 많음

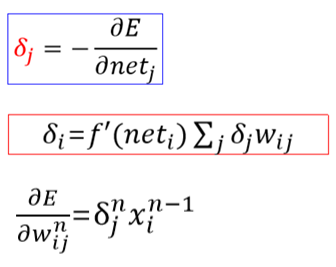

하나의 기호로 묶어서 사용하고자 함

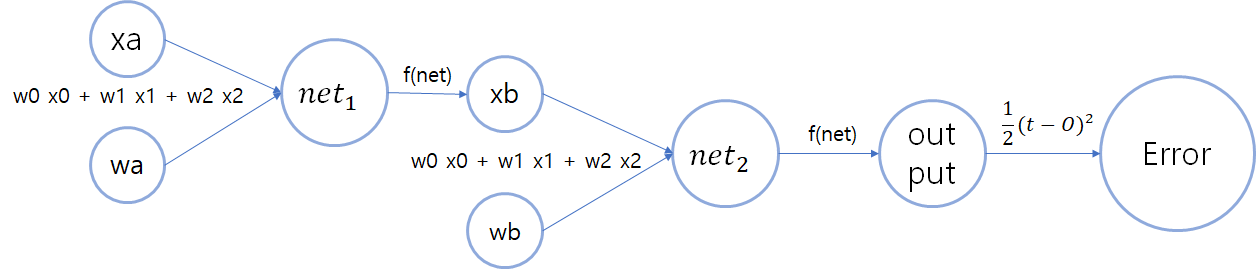

2layer perceptron을 다음과 같이 표현한다면 x,w로 net을 계산하고 activation function(f)을 거쳐 output을 내는 부분이 중복된다.

식으로 나타내면 다음과 같다. 여기서 파란색 글자와 주황색 글자는 변수만 다를 뿐 같은 식으로 나타낼 수 있다. 이렇게 겹치는 부분을

이렇게 나타내기로 해보자.

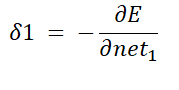

그렇다면 δ1 은 δ2 에서

를 곱한 것이다.

이고

인데,

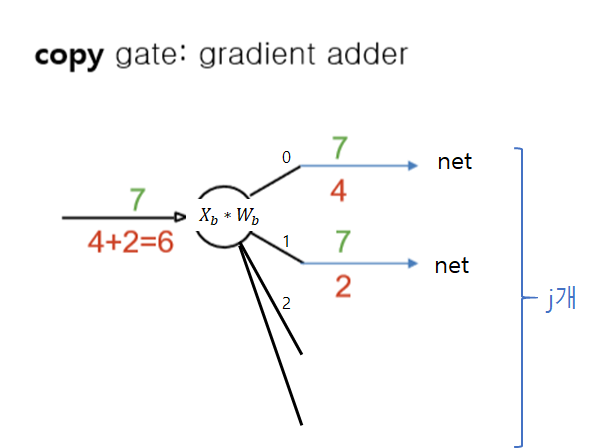

X0,X1,... 에 대해 모두 계산해야 하므로

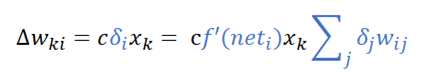

로 표현할 수 있다. 어려우니 그림으로 다시 살펴보자.

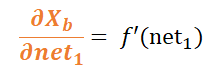

현재 δ2를 계산하고 알고 있는 상황에서 δ1를 쉽게 계산하려면 빨간색 화살표만 따라가면 된다. 하지만 xb와 wb를 곱해서 net2를 만드는 연산은 실제로 j개의 x,w에 대해서 곱하고 더하는 연산을 하여 net2를 생성한다. 따라서 X0,1,...,j 까지의 편미분 값을 구하려 할 때, 각각에 대치하여 W0,1,...,j 가 나온다.

net2 = w0*x0+w1*x1+... 이므로 net2를 x0로 편미분하면 w0, x1으로 편미분하면 w1가 나온다.

하지만 모든 j개의 경우에 대해서 net2 값은 항상 같으므로 j개의 경우에 대해서 다음과 같은 형태를 띄고 있음을 알 수 있다.

따라서 backpropagation으로 편미분을 전파할 때, net에서 내려오는 모든 편미분을 더해주어야하는 것이다.

결론

이러한 식으로 좀 더 쉽게 역전파를 계산할 수 있다.

과정으로 나타내자면

-

forward sweep

-

error의 범위가 만족?

-

o => 끝

-

x => backward sweep

-

문제점

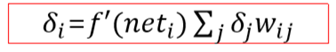

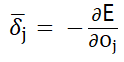

이러한 방식은 아래 층의 델타(δ)를 계산할 때, 아래 층의 f'(net) 값을 곱해야하기 때문에 위층에서 델타에 대한 계산을 끝낼 수가 없다. 이를 해결하려면

를 이용해야한다.

Lecun's backpropagation algorithm

라고 정의하는 방식으로 기존의 방식에서

를 제외하고 사용한다.

이로 인해,

이러한 식을 이용할 수 있다.

기존의 방식과는 다르게 net은 현재의 층(j층)에서 참고하면 되고 wij도 현재의 층에서 존재하므로 아래 층(i층)의 어떤 값을 참조할 필요가 없어서 층별 분리가 가능하다.

- 독립적인 layer 계산 가능

- 층별로 module화 가능

- 층의 구조, 갯수가 상관없음

실습

소스파일 하나에 변수를 몰아두면.. 메모리할당 후 값 넣기랑 그냥 선언이랑 꼬일 수도 있음..

어떤 건 메모리 할당 후에 값을 넣으려고 했는데 어떤 변수는 선언 후에 메모리 할당하는 함수에서 쓰여야할 수도 있으니까 ^ㅠ^...

그냥 소스파일에서 쓰이는 변수는 각 소스파일에서 선언 및 메모리 할당 하기로 하자... (뻘짓맨!)

구현 실패하고 일단 진도 나가기로 함

'컴퓨터과학 (CS) > AI' 카테고리의 다른 글

| 인공지능 정리 [본론8] :: 인공신경망 설계 시 고려사항 정리! (0) | 2020.02.29 |

|---|---|

| 인공지능 정리 [본론7] :: 깊어진 인공신경망의 문제점? (0) | 2020.02.29 |

| 인공지능 정리 [부록] :: theta가 필요한 이유 (0) | 2020.02.10 |

| 인공지능 정리 [본론5] :: 신경망의 원리 (0) | 2020.02.09 |

| 인공지능 정리 [부록] :: Restricted Boltzmann Machine (RBM) (0) | 2020.02.08 |

Comment